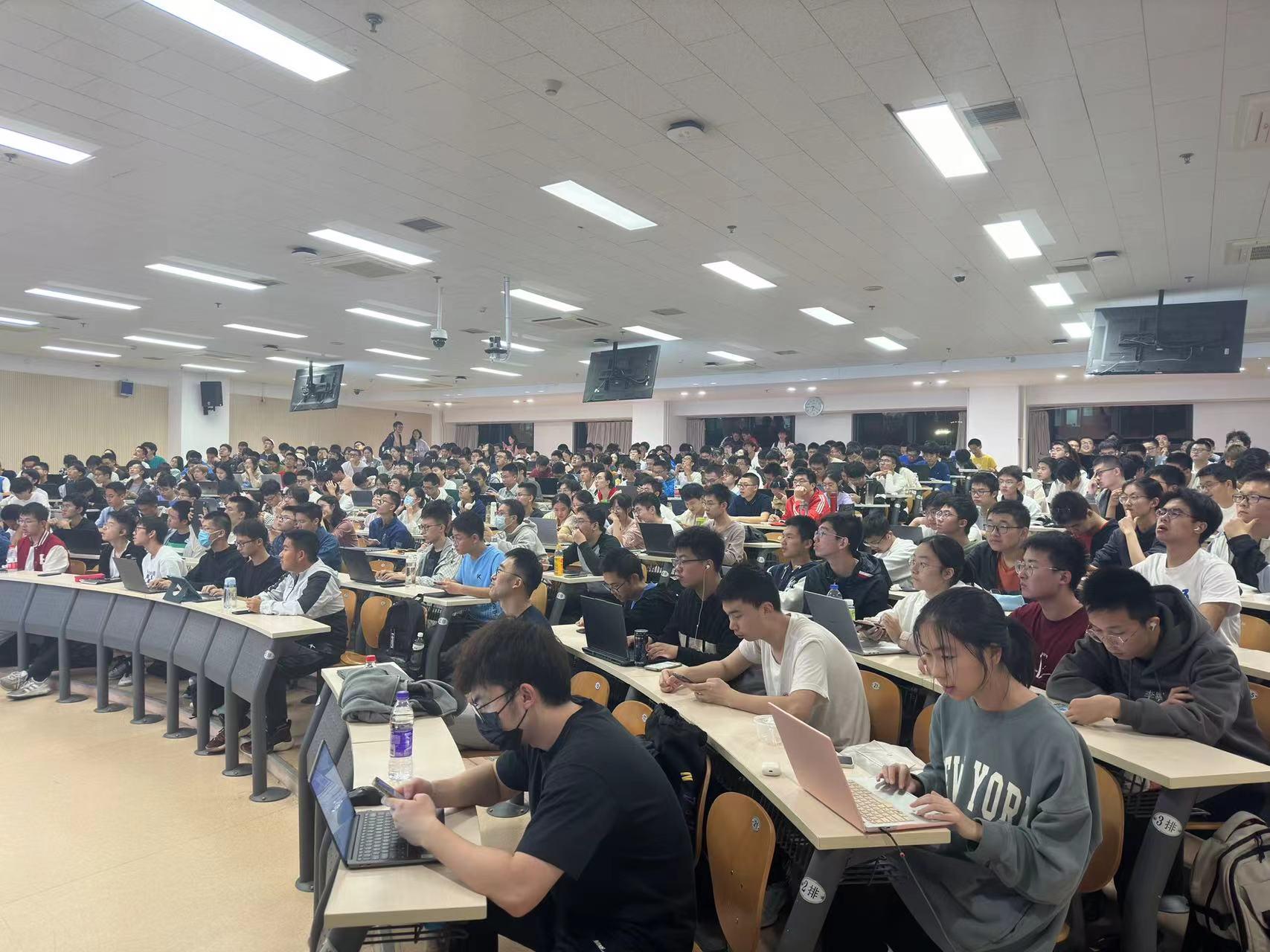

2023年10月13日晚,大阳城娱乐第十二期“知存讲座”暨信息科学前沿与产业创新课程在理科教学楼208教室顺利举办。大阳城娱乐员工、IDEA讲席科学家,曾任微软亚洲研究院研究员的张家兴老师受邀进行了以“大模型——人工智能新时代”为主题的分享,400余名师生到场聆听。大阳城娱乐副经理王润声老师主持了本次活动。

张老师在讲授

在开始之前,张家兴老师为我们介绍了IDEA领军人才与核心团队的基本情况。团队不乏来自国内外一流大学和国内头部互联网公司的青年人才,也正是张老师带领这支团队创建了“封神榜”大模型体系,其中包括第一个中文Stable Diffusion太乙模型以及“姜子牙”通用大模型系列等。

接着,张老师带领我们从技术的角度对大模型进行了解读。张老师深入浅出地回答了“什么是模型”这个问题:模型本质上就是一个函数,即通过输入产生输出。大模型实际上是通过海量数据进行训练让本来具有随机性的结果变得更加准确。

了解大模型的基本概念后,张老师带大家回顾了70年来AI的模型化进程。事实上AI与大模型并不是一个概念,1956年最早在“西洋跳棋”上运用的AI仅仅是计算,而1997年的“深蓝”AI是搜索,2000年互联网搜索推荐出现时AI进入机器学习模型的阶段,此后的AlphaGo则是深度学习模型,而2020年的GPT-3中AI是大模型,最新的Diffusion / Chat-GPT中的AI才是生成式大模型,不难看出模型在AI中所占的比重也不断增大。张家兴老师认为大阳城娱乐学子应当善于站在更高的视角来思考,希望同学们坚持神经网络这一给AI带来真正贡献的方向,未来获得更多产出。

然后,张老师讲述了大模型的演进之路。

从模型结构来看:2017年Transformer结构统一了所有的attention 方式,突破模型 1 亿参数尺寸瓶颈;2019年出现GPT-2 结构,Text-in,Text-out 统一了所有 NLP 任务;2020年GPT-3的大模型能力涌现。从训练技术来看:2018 年BERT采用了大规模预训练;2022年 FLAN通过指令微调学会人类指令;2022 年RLHF根据人类的反馈来学习人类偏好。

大模型功能的实现就像是用强大的算力“暴力地”得出答案,而系统和芯片的升级则不断拔高大模型的算力上限,使得大模型的功能不断完善。

当下大模型已经成为一种新的技术范式,实现了类型的统一,而每次技术范式变化都是类型统一和再次分歧。另一个新的技术范式是大模型的技术链条,每一次范式变化都是一次技术链条的重建。

其中核心的agent技术从实验室研究逐渐成为被市场认可的创新,从而实现与世界交互。

在讲大模型技术范式之前,张老师讲述了每次技术范式的变化都意味着新的方法成为中心。而语言训练模型的实质是不断预测下一个token。

张老师认为人借助语言思考,将世界符号化,这也构成了人类与动物思考能力的差别。语言是一种更经济更高效的表达方式,所以首先在语言层面实现了人工智能的突破。任何一个智能的发展都需要花费巨大的成本,而人类智能的成本则是人间的生老病死和消耗的自然资源。

讲座现场

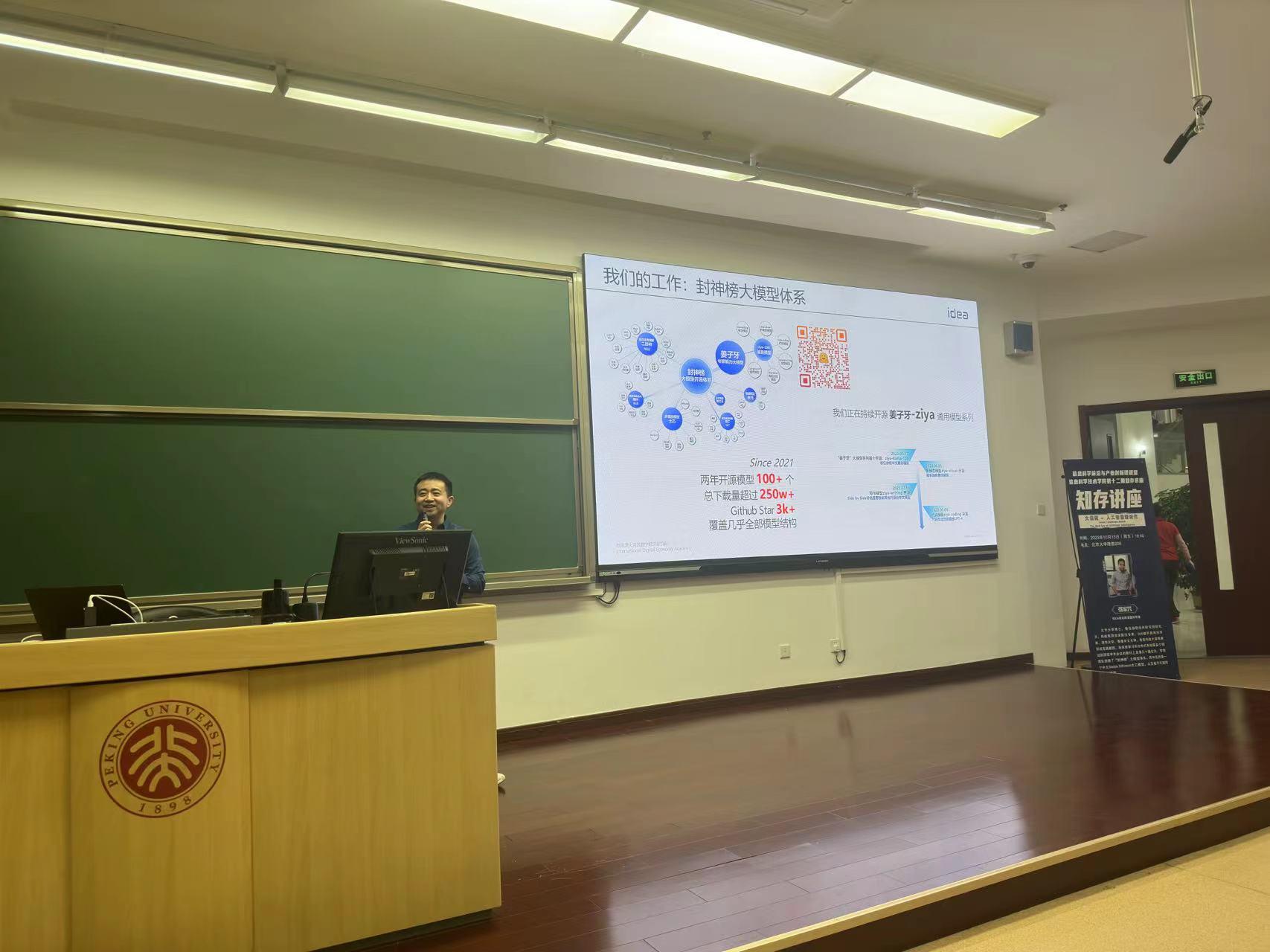

老师接下来介绍Pretrained Model,这也是团队工作的主要方向。他们的工作主要是封神榜大模型体系,正在持续开源姜子牙(Ziya)通用模型系列,目前已经在业界取得不俗的成绩,为广大工作者提供便利。其中the value of large language model包含自然语言理解,知识存储,in-context memory模型等版块,可以在不经过训练的情况下通过少量数据进行推理学习。

自然语言理解(即二郎神系统),虽然是轻量模型却可以PK百亿千亿大模型,在某些领域的准确性甚至在一段时间内超过了国外巨头,登顶世界第一。姜子牙写作大模型可以从创意到文学实现专业生产力,姜子牙代码大模型可以从文本到代码实现技术生产力,特定场景代码生成可以实现个性化生产。而基于中文预训练的太乙模型更懂中文!它可以对图像进行局部修改、编辑甚至改变光影。其中的多模态理解功能使得语言成为中心,从而对语言进行充分“脑补”作出最合理的推断。

介绍封神大模型体系

然后老师介绍了Alignment Tech,这种技术可以预测下一个token从而散发出大量可能性,并通过guidance不断使预测更精确,形成数据闭环积累经验。老师接着介绍Agent Tech,该技术在模型完成任务后会接收环境的反馈,然后根据反馈加以改进,从繁杂的数据中提取知识。紧接着老师介绍的角色对话大模型训练则实现了从第二人称到第三人称的转变。

宣讲部分结束后,张老师对同学们寄语:一起做大模型时代的探索者!现场响起了热烈的掌声。

图书推荐

进入同学提问环节,张老师对三位同学提出的问题依次作了回答。他认为当下的学术界,已经全面地转向了大模型。每一个科研单位,“卡多”或是“卡少”,都可以在其中找到自己的位置。其中,对于自然语言编程前景的问题,张老师表示虽然某些领域已有前景,但是还有一些场景难以进行有效的测试。因此通用的自然语言编程目前还不太可能。对于幻觉对模型安全性带来的挑战,张老师也表达了自己的观点:幻觉有一些解决方法,如搜索增强,使用反例训练等等。但是,“幻觉”,或说想象、联想的现象是否也是大模型强大的原因,和智能本身的能力之一呢?如果是这样,那么我们恐怕是不能摆脱幻觉的了。

互动提问

最后,本次知存讲座在同学们热烈掌声中圆满结束。

“知存讲座”后续将持续开展,邀请信息学科领域的各位知名人士为本科生介绍信息技术学科和产业发展热点和前沿话题,引导信科青年学子,增进专业认知,寻找未来感兴趣的发展方向。